Wir stellen vor: Mendix ML Kit für Low-Code ML-Bereitstellung

Low-Code-Anwendungsplattformen (LCAPs) sind ein aufstrebender Markt mit einem erwarteten Wachstum von rund 30 % in den nächsten Jahren. Fast zeitgleich mit dem Aufstieg des LCAP-Marktes im letzten Jahrzehnt hat ein neuer Frühling der künstlichen Intelligenz (KI) begonnen, angetrieben durch die kontinuierliche Zunahme der Rechenleistung in Kombination mit der Verfügbarkeit von Big Data.

Während LCAPs revolutionieren, „wie“ Anwendungen erstellt werden, revolutionieren KI und maschinelles Lernen (ML), „welche“ Art von Anwendungen erstellt werden können. Diese beiden Trends kommen zusammen, da LCAPs ausgereifter werden und von Unternehmen zum Erstellen komplexer unternehmenskritischer Apps eingesetzt werden. Daher sollte die nächste Generation von LCAPs das Erstellen sogenannter „KI-erweiterter Business-Apps“ unterstützen.

KI-gestützte Business-Apps – auch als Smart Apps bekannt – sind Apps, die ein KI/ML-Modell (oft in seiner Logik) verwenden, um eine automatisierte, intelligentere und kontextualisierte Benutzererfahrung zu bieten.

In 2020, Gartner sagte voraus dass „60 % der Organisationen bis 2022 verpackte künstliche Intelligenz nutzen werden, um Prozesse in mehreren Funktionsbereichen zu automatisieren“. Dies geschieht bereits. Ein McKinsey Umfrage Eine im Jahr 2021 durchgeführte Umfrage unter 1,843 Teilnehmern aus allen Regionen und Branchen ergab, dass „56 % der befragten Unternehmen KI in mindestens einer Geschäftsfunktion eingeführt haben (gegenüber 50 % im Jahr 2020).“

Anwendungsfälle für intelligente Apps

KI-gestützte Business-Apps nutzen Muster in den Daten, um Vorhersagen zu treffen, anstatt sie explizit zu programmieren. Dies führt häufig zur Automatisierung manueller Arbeit oder zu einem intelligenteren Ansatz für eine Aufgabe oder einen Geschäftsprozess. Dadurch wird die Effizienz am Arbeitsplatz gesteigert, Kosten und Risiken gesenkt und die Kundenzufriedenheit verbessert. Nachfolgend finden Sie einige Beispiele für Anwendungsfälle von KI und ML.

Sentimentanalyse und Klassifizierung

- Verstehen Sie die Stimmung im Kundenfeedback (positiv vs. negativ)

- Kategorisieren Sie Kundenfeedback oder -anfragen in bestimmte Support- oder Geschäftskategorien.

Objekterkennung

- Erkennen defekter Produkte in einer Fabrikproduktlinie

- Erkennen Sie den Defekttyp in den Produkten einer Fabrikproduktlinie

- Klassifizieren Sie Bilder für medizinische Bilder

- Objektzählung in einer Fabrik

Anomaly Detection

- Erkennen Sie verdächtige Banktransaktionen

- Abnorme Beziehung zwischen Geschäftsmetriken (z. B. Anstieg der Produktverkäufe, aber Umsatzrückgang aufgrund eines falschen Preises)

- Anomalieerkennung im Inventar

Empfehlungen

- Empfehlung des besten Angebots an die Versicherungsvertreter auf Basis der Kundenbedürfnisse

- Empfehlung alternativer Produkte oder Dienstleistungen für Online-Käufer auf Grundlage der zuvor gekauften Produkte

Forecasting

- Prognose des Cashflows auf Grundlage historischer und saisonaler Trends

- Prognostizieren Sie den erforderlichen Lagerbestand auf Grundlage der Verkaufstrends

- Nachfrageprognose für eine Hotelkette unter Verwendung interner und externer Faktoren

- Dynamische Preisgestaltung auf Basis der Nachfrageprognose

Die Herausforderungen der ML-Bereitstellung

Die KI/ML-Landschaft und -Tools wurden in den letzten Jahren erheblich weiterentwickelt, aber der Einsatz von KI in der Produktion und die Integration von KI in Anwendungen stellen eine zentrale Herausforderung dar.

Basierend auf Gartners Forschung„Unternehmen berichten, dass die Integration in bestehende Anwendungen eines der größten Hindernisse bei der Einführung von KI ist.“ Gartner zitiert ein Jahr später die gleiche Herausforderung: „Mehr als die Hälfte der erfolgreichen KI-Pilotprojekte schaffen es nie bis zur Einsatzphase.“

Bisher Mendix Kunden konnten KI-Dienste integrieren mit Mendix Apps, die REST-APIs verwenden. Dies ist ein praktikabler Ansatz (insbesondere für KI-Dienste von Drittanbietern). Allerdings erfordern lokal erstellte oder Open Source-ML-Modelle Zugriff auf einen Hosting-Dienst und technische Kenntnisse, um das Modell bereitzustellen, zusätzlichen Aufwand zu betreiben und zusätzliche Hosting- und Wartungskosten zu verursachen.

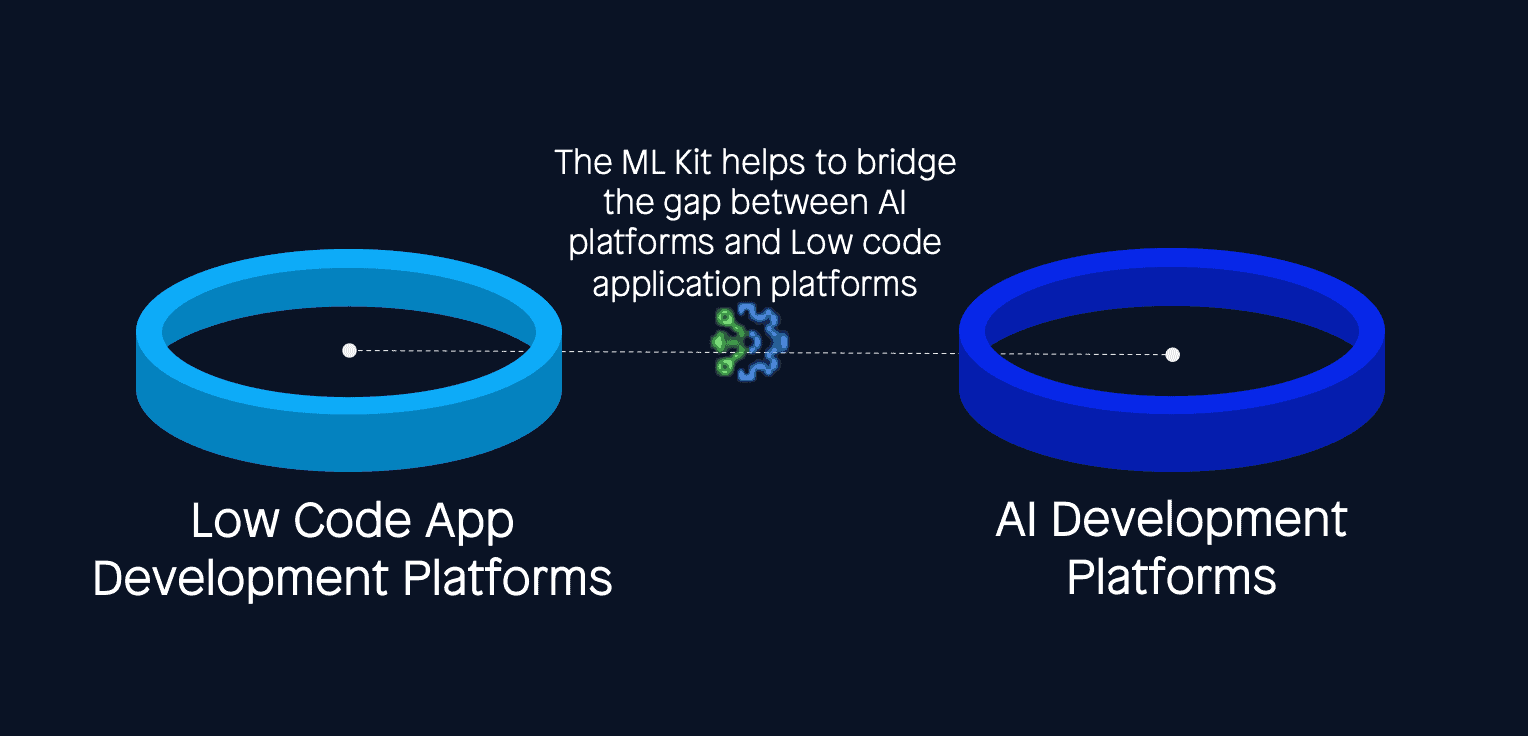

Aber oft müssen Kunden ihre ML-Modelle in ihre Mendix App aus verschiedenen Gründen, wie Leistung, Datenschutz und Kosten. Die Mendix ML Kit bietet Kunden die Werkzeuge, um diese KI-Modelle in einem Mendix App auf einfache Weise und mit wenig Code.

Low-Code-Bereitstellung mit dem Mendix ML-Kit

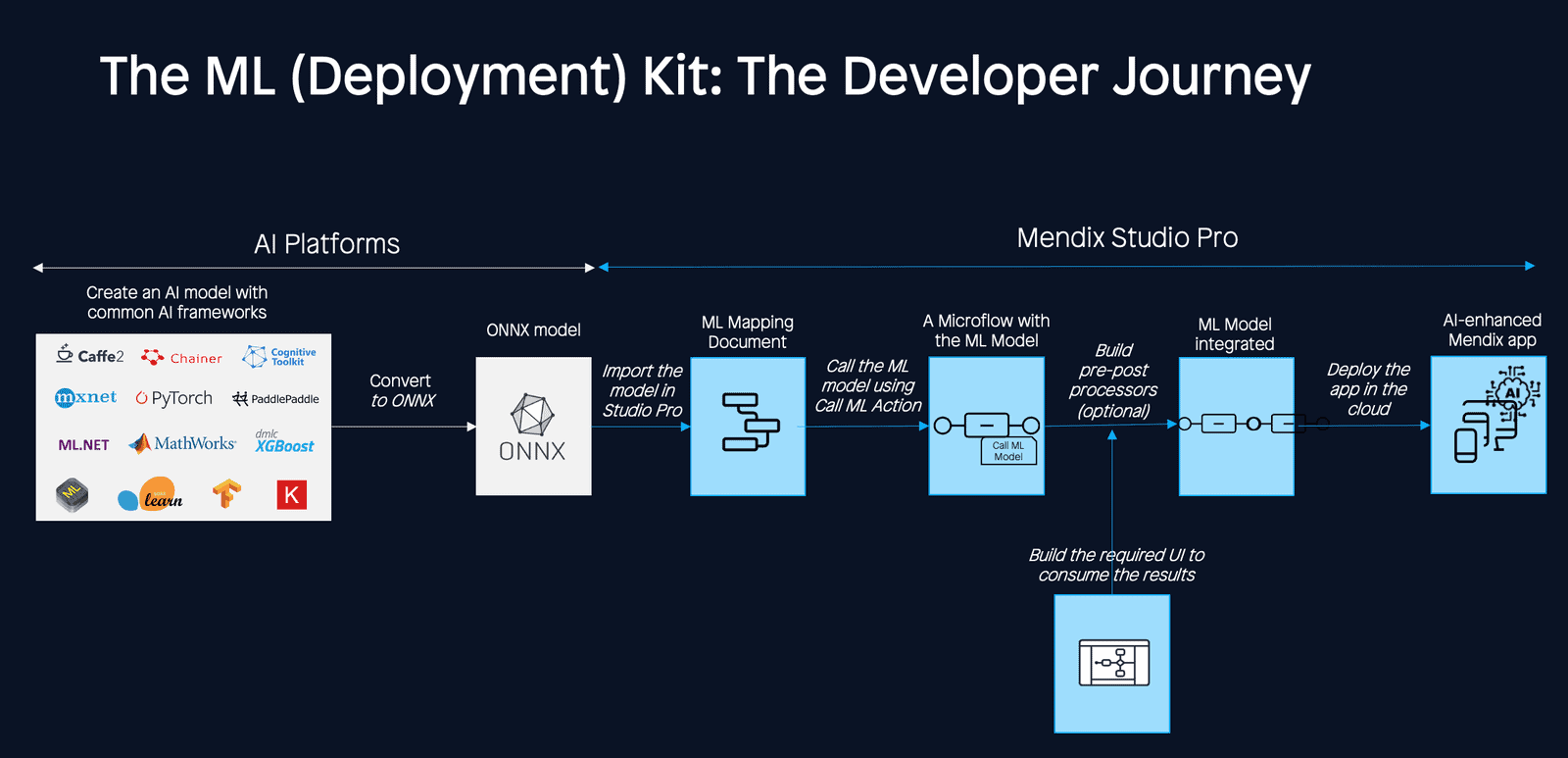

Der Mendix Mit ML Toolkit können Entwickler ein ML-Modell, das mit einem gemeinsamen ML-Framework und einer gemeinsamen ML-Sprache erstellt wurde, in das Mendix Studio Pro-Laufzeit mit wenig Code.

Das ML Kit basiert auf dem Open Neural Network Exchange (ONNX), ein Open-Source-Framework, das von Microsoft und Facebook gemeinsam entwickelt wurde im Jahr 2017 angegeben um Framework-Interoperabilität zu ermöglichen. ONNX ermöglicht es uns, die Lücke zwischen KI-Frameworks (z. B. Python) und Mendix (z. B. JVM). Das bedeutet, dass Sie ein ML-Modell in Ihrem bevorzugten ML-Framework wie TensorFlow trainieren, es dann in das ONNX-Format konvertieren und in einem anderen Framework wie MendixONNX schließt die Lücke zwischen KI-Frameworks (z. B. Python) und Mendix (z. B. JVM).

Vorteile der Mendix ML-Kit

Der Mendix ML Kit bietet verschiedene Vorteile:

- Schnellere Time-to-Market indem die Zeit bis zur ML-Bereitstellung von Wochen auf Tage/Stunden verkürzt wird.

- Einfachere Integration indem wir die beiden Welten – KI-Plattformen und LCAPs – verbinden und es Teams ermöglichen, ML-Modelle, die mit KI-Plattformen von Drittanbietern erstellt wurden, in Apps zu integrieren, die mit Mendix.

- Überlegene Leistung, dank geringerer Latenz (Netzwerk- und Modellinferenzlatenz) durch Integration des Modells in die App-Laufzeit und Ausführung auf JVM.

- Geringerer Aufwand und Kosten ohne dass für die Modellbereitstellung andere Hostingdienste erworben, bereitgestellt oder gewartet werden müssen (im Vergleich zur Microservices-Integration).

- On-Edge-Bereitstellung (Zukunft) bietet dank Laufzeitintegration die Möglichkeit, On-Edge (On-Device-ML) auszuführen. Es ist bemerkenswert, dass 60 % der Bildverarbeitungsmodelle mittlerweile On-Edge eingesetzt werden.

Sofort einsatzbereite, vorab trainierte ML-Modelle

Die ONNX-Community stellt ein ML-Modell-Repository bereit, genannt ONNX Model Zoo, wo gängige Computer Vision- und Sprachmodelle zu finden sind. Der ONNX Model Zoo ist eine Sammlung vorab trainierter, hochmoderner Modelle im ONNX-Format, die von Community-Mitgliedern beigesteuert werden.

Zu jedem Modell gehören Jupyter-Notebooks für das Modelltraining und das Ausführen von Inferenzen mit dem trainierten Modell. Die Notebooks sind in Python geschrieben und enthalten Links zum Trainingsdatensatz sowie Verweise auf das Originaldokument, in dem die Modellarchitektur beschrieben wird.

Alle ONNX-Modelle im ONNX Zoo sollten mit dem ML Kit kompatibel sein. Kunden können jedes ML-Modell aus diesem Repository auswählen, es mit ihren eigenen Daten für ihren Anwendungsfall anpassen und in ihre Mendix App mit dem ML Kit.

Unten finden Sie die Liste der ONNX-Modelle im ONNX Model Zoo. Sie können diese vorab trainierten Modelle verwenden, um Ihre Geschäftsanwendungsfälle ähnlich den oben aufgeführten oder andere Arten von Anwendungsfällen für Ihr Unternehmen zu erstellen.

Vision

- Bildklassifizierung

- Objekterkennung und Bildsegmentierung

- Körper-, Gesichts- und Gestenanalyse

- Bildmanipulation

Sprache

Andere

- Visuelle Fragen- und Antwortfunktion und Dialog

- Sprach- und Audioverarbeitung

- Weitere interessante Modelle

Erweiterte Bereitstellungsmuster mit dem Mendix ML-Kit

Der Mendix ML Kit kombiniert mit dem Mendix Die Plattform ermöglicht verschiedene hochmoderne ML-Implementierungsmuster.

Manchmal werden mehrere ML-Modelle verwendet, um eine Ausgabe vorherzusagen. Dabei werden dieselben Datenpunkte an eine Gruppe von Modellen gesendet und dann alle Vorhersagen gesammelt, um die beste Vorhersage zu finden (Ensemble-Lernen). Oder es können mehrere Modelle kaskadiert verwendet werden, um die Ausgabe eines Modells in ein anderes einzuspeisen (kaskadierte Inferenz). Diese Bereitstellungsmuster können einfach erreicht werden mit Mendix Mikroströmungen und die Mendix ML-Kit.

Darüber hinaus ist die Integration eines ML-Modells als Service auch nur über die Mendix Plattform und das ML Kit, ohne dass zusätzliche Hosting-Dienste von Drittanbietern erforderlich sind. Und nicht zuletzt wird Batch-Inferenz, bei der mehrere Inferenzen mit einer einzigen Anforderung für das Modell ausgeführt werden, unterstützt mit Mendix und den Mendix ML-Kit.

Sie können lesen, wie Sie alle diese Bereitstellungsmuster mit dem ML Kit implementieren und Mendix Studio Pro auf den folgenden Seiten:

Zusammenfassung

Mit dem ML Kit möchten wir Kunden in die Lage versetzen, KI in ihren Apps zu nutzen, um Geschäftsprozesse weiter zu verbessern, manuelle Aufgaben zu automatisieren und die Kundenzufriedenheit zu steigern. Wenn Sie das noch nicht verwendet haben Mendix ML Kit noch nicht kennen, probieren Sie es aus. Und teilen Sie uns Ihre Meinung mit – Ihr Feedback ist oft die Grundlage für unsere nächste Iteration

Um mehr über das erfahren Mendix ML Kit und wie man es benutzt, besuchen Mendix DocsOder finden Sie Beispiele für den Einsatz von ML mithilfe der Mendix ML KIT begleitet von ihren ML-Modellen im Jupyter-Notebook here.