So konfigurieren Sie Azure OpenAI-Modelle in Mendix

Vor kurzem verbrachte ich einige Zeit Zusammenarbeit mit dem Gen AI für Mendix Modulen. Mir ist aufgefallen, dass es auch andere KI-Modelle als OpenAI unterstützt., in Tatsache, dass es Azure unterstützen kann, EinMazon Bedrocksowie mit ein wenig Einfallsreichtum – an jedes große Sprachmodell angepasst. Ich war beeindruckt von dem Modul und seiner Benutzerfreundlichkeit. Ich entschied zu Experimentieren und Finden Sie heraus, wie unterschiedlich der Prozess sein könnte wenn ich das LLM gegen ein anderes austausche – in diesem Fall habe ich mich für die Verwendung von Azure entschieden.

Bevor wir anfangen

PVoraussetzungen:

Wenn Sie mit der Gen AI für Mendix Modul, sehen Sie sich meinen vorherigen Artikel darüber an, was es ist und wie man es verwendet:

Ich werde die Grundeinstellung überspringen des Marketplace-Moduls Diesmal, da ich das bereits behandelt habe. Ich würde lieber Kursinhalt zu den Unterschieden, beginnend mit dem Hinzufügen einer Azure-Verbindung und dem Einrichten eines bereitgestellten Modells.

Einrichten eines Azure-Kontos

Die Einrichtung Ihres Azure-Kontos ist einfach und schnell; Sie haben die Wahl zwischen einem kostenlosen Konto oder zahlen, wie Sie gehen. Das kostenlose Konto beginnt mit 200 $ Guthaben für Sie, wenn Sie Erstelle deinen Account. Weitere Informationen zum Preisleitfaden von Azure für Open AI-Dienste finden Sie hier. hier.

Erstellen und deinen A einsetzenzure Open AI rQuelle

So richten Sie ein Asauer OStiftAI Ressourcen, folgen dem Leitfaden von Asauer's Dokumentation.

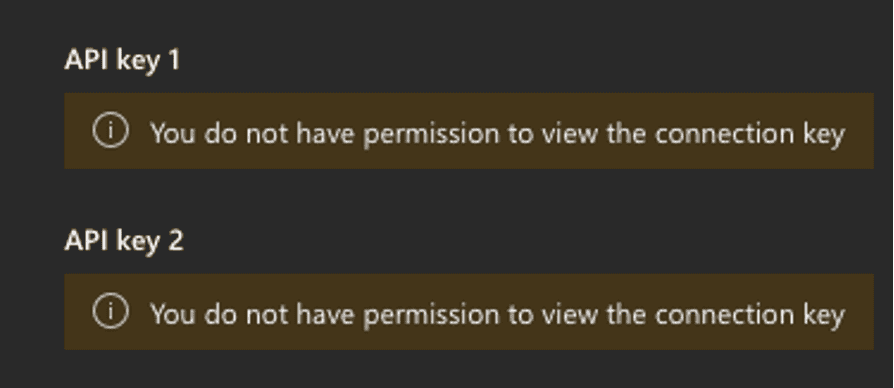

Wenn Sie Ihre Ressource nicht erstellt haben, müssen Sie den Zugriff beim Eigentümer anfordern zu bestimmte Details anzeigen und darauf zugreifen (swie der API-Schlüssel), sonst können Sie ihn möglicherweise nicht standardmäßig anzeigen.

Konfigurieren von a deingesetzt modell

Nachdem Sie Ihre Ressource bereitgestellt haben auf Azure-Portal, es'eine einfache Sache des Hinzufügens und Konfigurierens der deingesetztes Modell in Mendix. Run Ihre App und navigieren Sie zu Admin Seite „Konfigurationsübersicht“ oder zu einer Seite, die Folgendes enthält: das Snippet „Snippet_Configurations“ um die bereitgestellten Modelle zu konfigurieren.

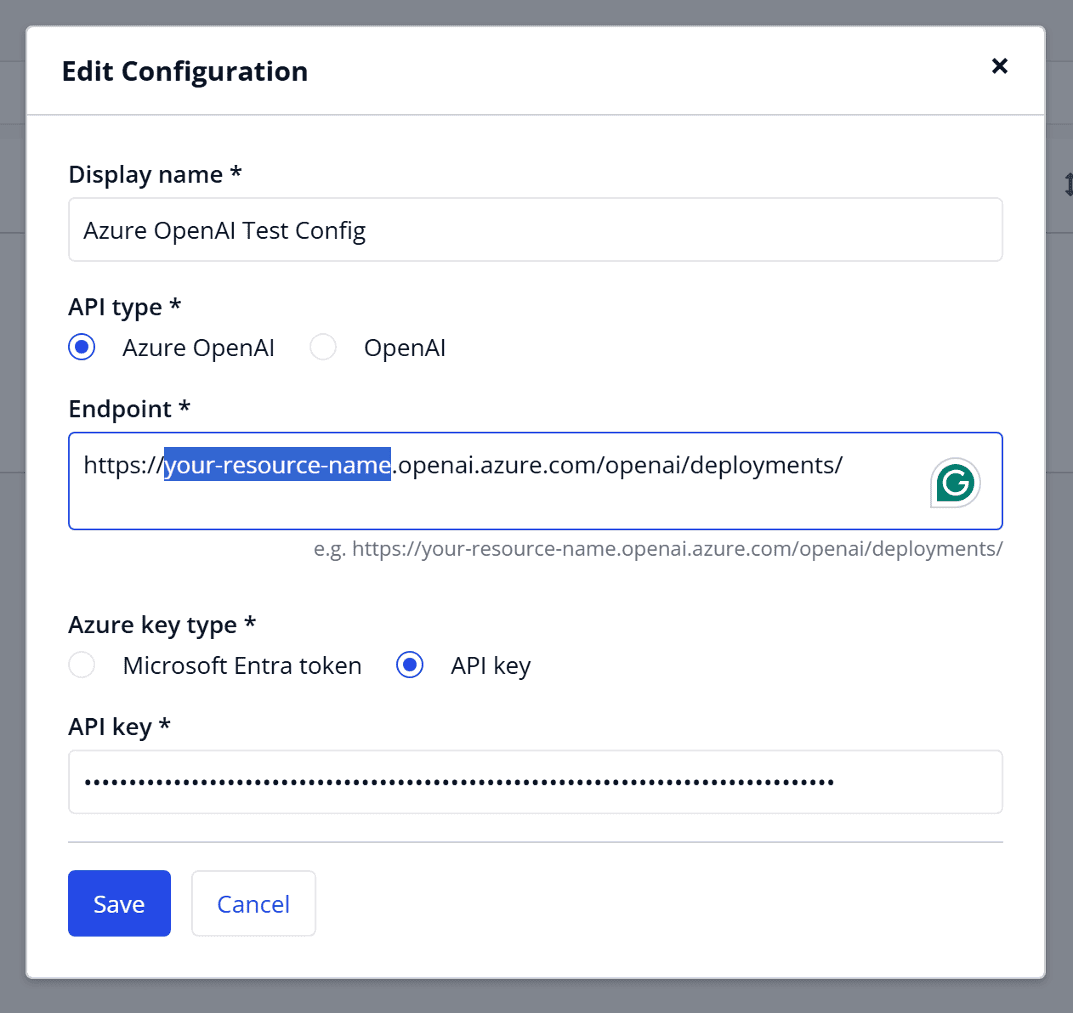

Wählen Sie, um eine neue Konfiguration hinzuzufügen. Im Popup-Fenster, das erscheint, Geben Sie ein "Display-Name“ (kann eine beliebige Zeichenfolge sein/nur zur Anzeige), legen Sie Ihren „API-Typ“ auf „Azure OpenAI“ fest und geben Sie unter „Endpunkt“ die URL zu Ihrer Ressource auf Azure ein. Schließlich Sie können Ihren API-Schlüssel eingeben, den Sie im Dashboard für Ihre Ressource finden unter Azure (iwenn Sie nicht eingestellt haben Wenn Sie die Ressource eingerichtet haben, müssen Sie möglicherweise den Zugriff von der Person anfordern, die dies getan hat.

Nach dem Klicken auf „Speichern“ wird das Fensterw wird geschlossen und durch ein neues ersetzt, um „Bereitgestellte Modelle verwalten“ für die Konfiguration zu verwenden. Im Gegensatz zur OpenAI-Konfiguration werden die bereitgestellten Modelle nicht automatisch generiert – und wir sollen fügen Sie manuell eine hinzu.

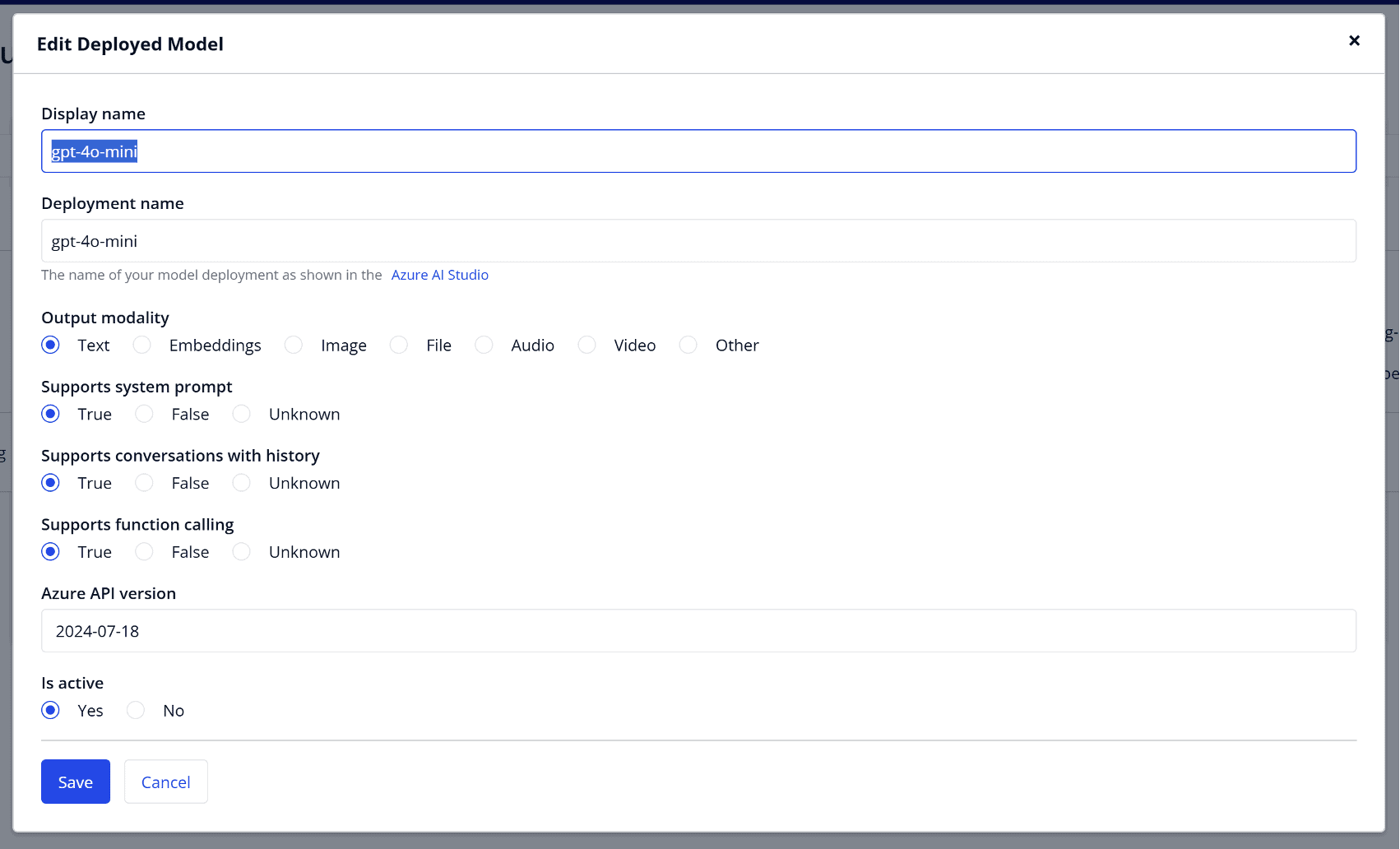

Klicken Sie dazu einfach auf „Bereitgestelltes Modell hinzufügen“und geben Sie die im Formular angeforderten Details ein. Auch hier dient „Anzeigename“ nur zur Anzeige und kann beliebig sein. Wichtiger ist, dass „Bereitstellungsname“ genau mit der Anzeige im Azure AI Studio übereinstimmt. Diese finden Sie unter „Bereitstellungen“ im linke Hand Seitenbereich und es ist der Wert in der ersten Spalte der Tabelle. Sie müssen auch Ihre „OAusgabemodalität“, die vom erwarteten Ergebnis abhängt. Verschiedene Modelle unterstützen unterschiedliche oAusgabe Modalitäten, und Sie müssen prüfen, welches Ihr Modell unterstützt (Text, Einbettungen, Bild, Datei, Audio, Video und andere). Wenn Sie Text als Ausgabe auswählen, müssen Sie auch Werte für "Unterstützt Systemaufforderung“, „Unterstützt Gespräche mit Verlauf“ und „Unterstützt Funktionsaufrufe“.

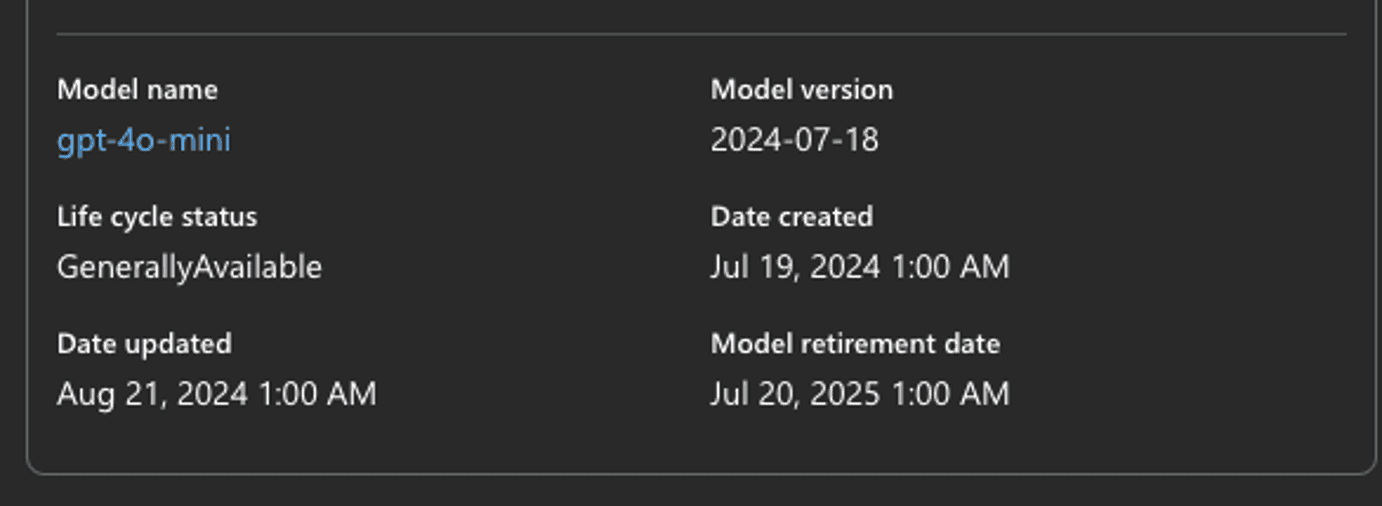

Schließlich Sie müssen einen Wert für die „Azure API-Version“ hinzufügen und dieser muss auch mit der Konfiguration in Azure Studio übereinstimmen. Azures Versionen basieren auf Datumsangaben im Format „JJJJ-MM-TT“. Sie finden diese Angaben im dritte Spalte auf der Seite „Modellbereitstellungen“, und es befindet sich auch auf der Seite, wenn Sie die Details eines Modells öffnen, ganz unten.

Klicken Sie anschließend auf Speichern und schließen Sie die bereitgestellte Modelle

Testen der new modell

Genauso wie vorher, Wir können die Konfiguration testen. Maus über auf die drei Punkte Menü, um die Optionen für die Konfiguration aufzurufen.

Wählen Sie Ihr bereitgestelltes Modell aus der Dropdown-Liste aus-nach unten menü Klicken Sie auf die Schaltfläche „Testen“. Falls etwas nicht stimmt, wird eine rote Meldung angezeigt. Überprüfen Sie Ihre Anwendungsprotokolle auf weitere Informationen zur Fehlerbehebung. Sie finden den Fehler im Protokollknoten „Open AI Connector“ in der Studio Pro-Konsole.

Wesentliche dUnterschiede

Der größte Unterschied zwischen dem OpenAI-Dienst von Azure und der einfachen direkten Nutzung von Open AI is zur Abwicklung, Integrierung, Speicherung und Azure ermöglicht verbesserte Kontrolle, auf Kosten einiger zusätzlicher Konfiguration. Während I würde das nicht empfehlen für jemand Da ich dies zum ersten Mal mache, glaube ich, dass es die bessere Option für Enterprise-Anwendungen ist. Die Preise von Azure können auch günstiger ausfallen auf lange Sicht und bietet gleichzeitig die zusätzlichen Vorteile verbesserter Sicherheits- und Compliance-Optionen.